فایل Robots.txt چیست و چه کاربردی دارد؟

فایل روبوت دات تکست (Robots.txt) به اسپایدرها یا خزنده های موتورهای جستجو میگوید که در صفحات یا بخشهای خاصی از یک وبسایت، نخزند یا آن را کراول نکنند. اکثر موتورهای جستجوی اصلی (از جمله گوگل، بینگ و یاهو) درخواستهای Robots.txt را میشناسند و به آنها پایبند هستند.

فایل Robots.txt چه اهمیتی دارد؟

اکثر وب سایتها به فایل robots.txt نیازی ندارند. چون گوگل در حالت عادی میتواند تمامی صفحات مهم سایت را پیدا کرده و ایندکس کند.

موتورهای جستجو به طور خودکار، صفحات بی اهمیت یا نسخههای تکراری سایر صفحات را ایندکس نمیکنند.

با این حال، 3 دلیل اصلی برای استفاده از فایل robots.txt وجود دارد:

مسدود کردن صفحات غیر عمومی

گاهی اوقات صفحاتی در سایت دارید که نمیخواهید ایندکس شوند. برای مثال، شاید صفحه سبد خرید یک فروشگاه اینترنتی یا یک صفحه لاگین برای ادمین های سایت دارید. وجود این صفحات، الزامی هستند ولی نمیخواهید افراد متفرقه از طریق موتورهای جستجو و مستقیما واردشان شوند. در این موارد، از فایل robots.txt برای مخفی کردن این صفحات از دید کراولرها و رباتهای موتور جستجو استفاده کنید.

به حداکثر رساندن بودجه کراول

اگر برای ایندکس شدن همه صفحات، مشکل دارید، شاید با مشکل بودجه کراول مواجه هستید. از طریق مسدود کردن صفحات بیاهمیت با فایل robots.txt به Googlebot اجازه میدهید تا بودجه کراول سایت شما را بیشتر صرف صفحات مهم کند.

جلوگیری از ایندکس شدن منابع

دستورالعملهای متا (meta directives) به خوبی فایل robots.txt، از ایندکس شدن صفحات جلوگیری میکند. با این حال، این متاروبوت ها در مورد منابع چندرسانهای، مثل فایلهای PDF و تصاویر، عملکرد چندان خوبی ندارد. اینجاست که فایل robots.txt وارد عمل میشود.

خلاصه این که فایل Robots.txt به اسپایدرهای موتورهای جستجو میگوید که صفحات خاصی از وبسایت را کراول نکنند.

میتوانید تعداد صفحات ایندکس شده را در سرچ کنسول گوگل (Google Search Console)، بررسی کنید.

اگر تعداد به دست آمده با تعداد صفحاتی که میخواهید ایندکس شوند، مطابقت دارد، پس نیازی به فایل Robots.txt ندارید.

اما اگر این تعداد، بیشتر از چیزی است که انتظارش را داشتید (و متوجه URLهای ایندکس شدهای شدید که نباید ایندکس شوند)، وقت آن رسیده تا یک فایل robots.txt برای وب سایت خودتان تهیه کنید.

مطلب پیشنهادی: انواع داده های ساختار یافته نتایج گوگل

بهترین روشهای ساخت فایل Robots.txt

فایل Robots.txt تهیه کنید

اولین قدم این است که یک فایل Robots.txt ایجاد کنید.

این فایل متنی، با استفاده از notepad ویندوز هم قابل ساخت است. مهم هم نیست که در نهایت چگونه فایل robots.txt را میسازید، فرمت آن یکسان است:

نماینده کاربر (User-agent): X

غیر مجاز (Disallow): Y

نماینده کاربر، ربات خاصی است که در حال صحبت با او هستید.

و هر چیزی که بعد از «Disallow» میآید، شامل صفحات یا بخش هایی هستند که میخواهید مسدود شوند و ایندکس نشوند.

در اینجا به یک مثال توجه کنید:

نماینده کاربر: googlebot

غیر مجاز: images/

این قانون به Googlebot میگوید که پوشه تصویر درون وبسایت را ایندکس نکند.

همچنین میتوانید از یک ستاره (*) برای صحبت با همه رباتهایی که به وبسایت شما میرسند، استفاده کنید.

به مثالی در این زمینه توجه کنید:

نماینده کاربر: *

غیر مجاز: /images

علامت«*» به همه اسپایدرها میگوید که پوشه تصاویر شما را کراول نکنند.

این روش، تنها یکی از راههای استفاده از فایل robots.txt است. برای کسب اطلاعات بیشتر در مورد مسدود کردن صفحات مختلف سایت در برابر کراول شدن از جانب رباتها به جدول راهنمای گوگل مراجعه کنید.

پیدا کردن فایل Robots.txt را ساده کنید

هنگامی که فایل robots.txt را تهیه کردید، باید به آن جان دهید. از نظر فنی میتوانید این فایل را در هر کدام از دایرکتوریهای اصلی سایت قرار دهید.

اما برای افزایش شانس یافتن فایل، توصیه می کنیم که آن را در این آدرس قرار دهید:

https://example.com/robots.txt

توجه کنید که فایل robots.txt به حروف کوچک و بزرگ حساس است. بنابراین مطمئن شوید که از «r» کوچک در نام فایل استفاده کنید.

مطلب پیشنهادی: چک لیست سئو سایت

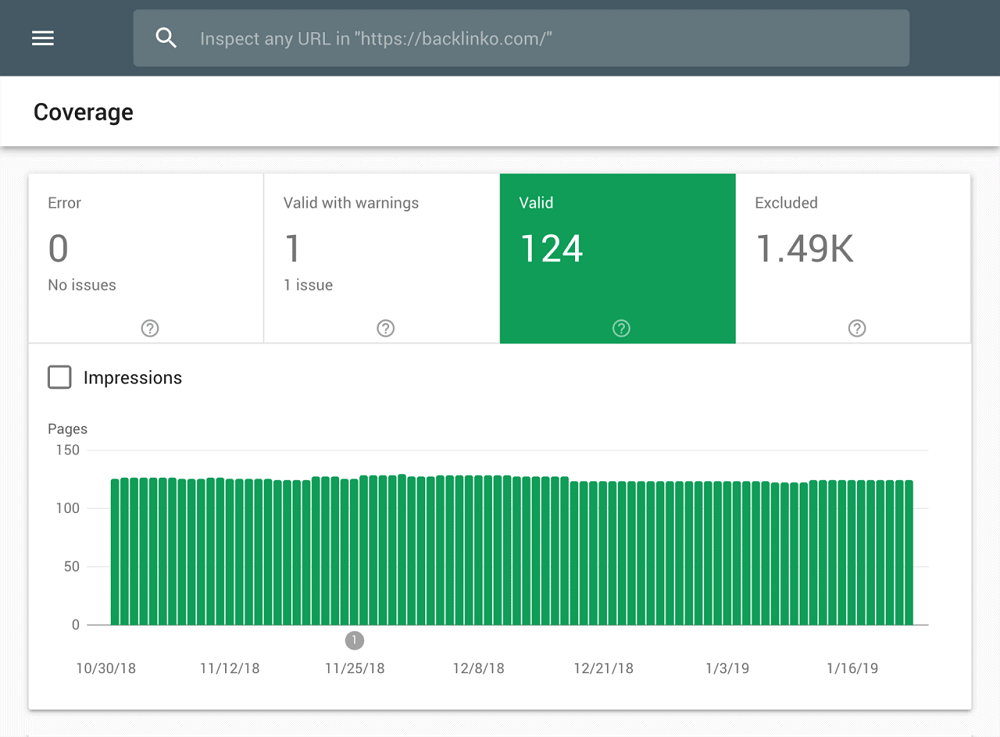

اشتباهات و ارورها را بررسی کنید

فایل robots.txt باید به درستی تنظیم شود. تنها با یک اشتباه، احتمال ایندکس نشدن کل سایت وجود دارد.

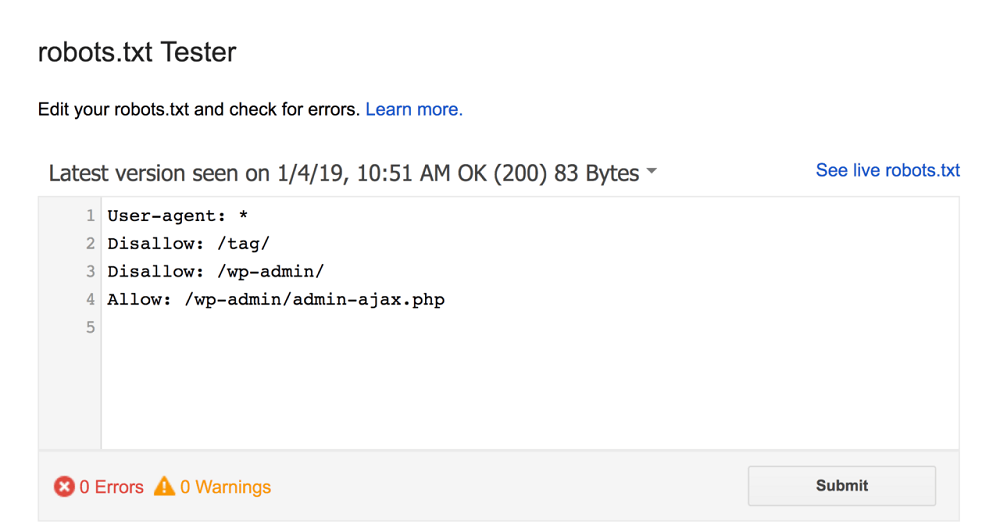

خوشبختانه، نیازی نیست که نگران تنظیم درست کد شوید. گوگل، ابزاری به نام Robots Testing Tool دارد که میتوانید از آن استفاده کنید:

این ابزار، فایل robots.txt و هر گونه ارور و هشداری را به صورت زیر نشان میدهد:

همان گونه که در مثال فوق مشاهده میکنید، از خزیدن اسپایدرها در صفحه WP admin (گه مربوط به ادمین های سایتهای وردپرسی است) جلوگیری کردهایم.

همچنین از فایل robots.txt برای جلوگیری از کراول شدن صفحات وردپرس auto-generated tag استفاده کردیم تا مانع از ایجاد محتوای تکراری شویم.

مطلب پیشنهادی: کدهای HTTP status چیست؟

فایل روبوت دات تکست (robots.txt) در مقابل دستورالعملهای متا (meta directives)

هنگامی که میتوانید با متاتگ «noindex»، صفحات را در سطح صفحه مسدود کنید، چرا باید از فایل robots.txt استفاده کرد؟

همانطور که قبلاً هم اشاره کردیم، تگ noindex برای منابع چندرسانهای مانند فیلمها و فایلهای PDF عملکرد خوبی ندارد.

بعلاوه، اگر هزاران صفحه در سایت را بخواهید مسدود کنید، پس به جای افزودن دستی تگ noindex به هر صفحه، مسدود کردن کل آن بخش از سایت با کمک فایل robots.txt آسانتر است.

شاید در مواردی هم نمیخواهید هیچ بودجه کراولی را با ورود گوگل به صفحاتی با تگ noindex، هدر دهید.

خارج از این 3 حالت بالا، توصیه میکنیم تا از دستورالعملهای متا (meta directives) به جای robots.txt استفاده کنید. چون پیاده سازی آنها آسانتر است و احتمال وقوع فاجعه (مانند مسدود شدن کل سایت) هم کمتر است.

.svg)